- Welcome to 网页制作专家.

ShadowRay漏洞:人工智能和网络安全的 6 个教训

ShadowRay 是 Ray 人工智能 (AI) 框架基础架构的漏洞。该漏洞正受到主动攻击,但 Ray 却辩称该漏洞是漏洞,并且不打算修复它。Ray 的开发人员与安全研究人员之间的争论凸显了隐藏的假设,并通过对 ShadowRay 的理解为 AI 安全、互联网暴露资产和漏洞扫描提供了教训。

ShadowRay 详解

AI 计算平台 Anyscale 开发了开源 Ray AI 框架,主要用于管理 AI 工作负载。该工具拥有包括 DoorDash、LinkedIn、Netflix、OpenAI、Uber 等在内的客户名单。

的安全研究人员发现了 CVE-2023-48022 ,又名 ShadowRay ,该漏洞指出 Ray 未能在 Jobs API 中应用授权。此漏洞允许任何未经身份验证且具有仪表板网络访问权限的用户启动作业,甚至在主机上执行任意代码。

研究人员计算出,使用通用漏洞评分系统 (CVSS),该漏洞应获得 9.8 分(满分 10 分),但 Anyscale 否认该漏洞属于漏洞。相反,他们坚持认为 Ray 仅供受控环境使用,并且缺乏授权是其预期功能。

ShadowRay 损坏

不幸的是,大量客户似乎不理解 Anyscale 的假设,即这些环境不会暴露在互联网上。Oligo 已经检测到数百台暴露的服务器,攻击者已经入侵,并将入侵类型分类为:

- 访问的 SSH 密钥:使攻击者能够连接到托管环境中的其他虚拟机,获得持久性并重新利用计算能力。

- 过度访问:由于嵌入的 API 管理员权限,为攻击者提供了通过 Ray 根访问或 Kubernetes 集群访问云环境的权限。

- 受损的 AI 工作负载:影响 AI 模型结果的完整性、导致模型被盗,并可能感染模型训练以改变未来结果。

- 劫持计算:将昂贵的人工智能计算能力重新用于满足攻击者的需求,主要是加密劫持,即利用被盗资源挖掘加密货币。

- 凭证被盗:通过暴露 OpenAI、Slack、Stripe、内部数据库、AI 数据库等的密码,使其他资源遭受攻击。

- 扣押代币:允许攻击者窃取资金(Stripe)、进行 AI 供应链攻击(OpenAI、Hugging Face 等)或拦截内部通信(Slack)。

如果您尚未验证内部 Ray 资源是否安全地位于严格的网络安全控制之下,请运行 Anyscale 工具来立即定位暴露的资源。

ShadowRay 间接教训

虽然直接损失对受害者来说将是巨大的,但 ShadowRay 暴露了在疯狂涌向云端和采用 AI 的过程中被忽视的隐藏网络安全假设。让我们在 AI 安全、互联网暴露资源和漏洞扫描的背景下检查这些假设。

人工智能安全课程

为了利用人工智能感知能力,公司将主动权交给人工智能专家,而这些专家自然会专注于他们的主要目标:获得人工智能模型结果。这是一种自然的短视,但公司忽略了 ShadowRay 暴露的三个关键隐藏问题:人工智能专家缺乏安全专业知识,人工智能数据需要加密,人工智能模型需要源跟踪。

人工智能专家缺乏安全专业知识

Anyscale 认为环境是安全的,就像 AI 研究人员也认为 Ray 是安全的一样。Orca Security的现场首席技术官 Neil Carpenter指出:“如果端点不进行身份验证,它至少可以有网络控制来默认阻止直接子网之外的访问。令人失望的是,作者认为这个 CVE 是故意设计的,而不是努力解决它。”

Anyscale 的回应与 Ray 的实际使用情况相比,凸显出人工智能专家缺乏安全意识。数百台暴露的服务器表明,许多组织需要为其人工智能团队增加安全性,或在其运营中纳入安全监督。那些继续假设安全系统的人将遭受数据合规性违规和其他损害。

人工智能数据需要加密

攻击者很容易检测并找到未加密的敏感信息,尤其是 Oligo 研究人员所描述的“模型或数据集”,即“独特的私有知识产权,使公司有别于竞争对手”。

AI 数据成为数据泄露和公司机密泄露的单点故障,然而在 AI 研究上投入数百万预算的组织却忽视了保护 AI 数据所需的相关安全支出。幸运的是,可以购买应用层加密 (ALE)和其他类型的当前加密解决方案来为内部或外部 AI 数据建模增加保护。

人工智能模型需要源跟踪

当 AI 模型消化信息进行建模时,AI 程序员会假设所有数据都是好数据,并且“垃圾进垃圾出”永远不会适用于 AI。不幸的是,如果攻击者可以将虚假的外部数据插入训练数据集,那么模型就会受到影响,甚至完全扭曲。然而,AI 数据保护仍然具有挑战性。

“这是一个快速发展的领域,”卡彭特承认。“然而……现有的控制措施将有助于防止未来对人工智能训练材料的攻击;例如,第一道防线将包括限制访问(包括身份和网络层),以及审核用于训练人工智能模型的数据的访问。保护包括人工智能训练在内的供应链与保护任何其他软件供应链一样,都需要坚实的基础。”

传统防御措施有助于保护内部 AI 数据源,但在整合组织外部的数据源时,防御措施会变得更加复杂。Carpenter 建议,第三方数据需要额外考虑,以避免“数据被恶意毒害、侵犯版权和隐性偏见”等问题。在将数据添加到用于 AI 模型训练的服务器之前,需要进行数据清理以避免这些问题。更多CDN常见问题。

也许有些研究人员认为所有结果都是合理的,甚至是人工智能的幻觉。然而,虚构或扭曲的结果会误导任何试图将结果应用于现实世界的人。需要对这一过程保持适度的怀疑态度,以激励人们追踪人工智能影响数据的真实性、有效性和适当使用。

互联网资源课程

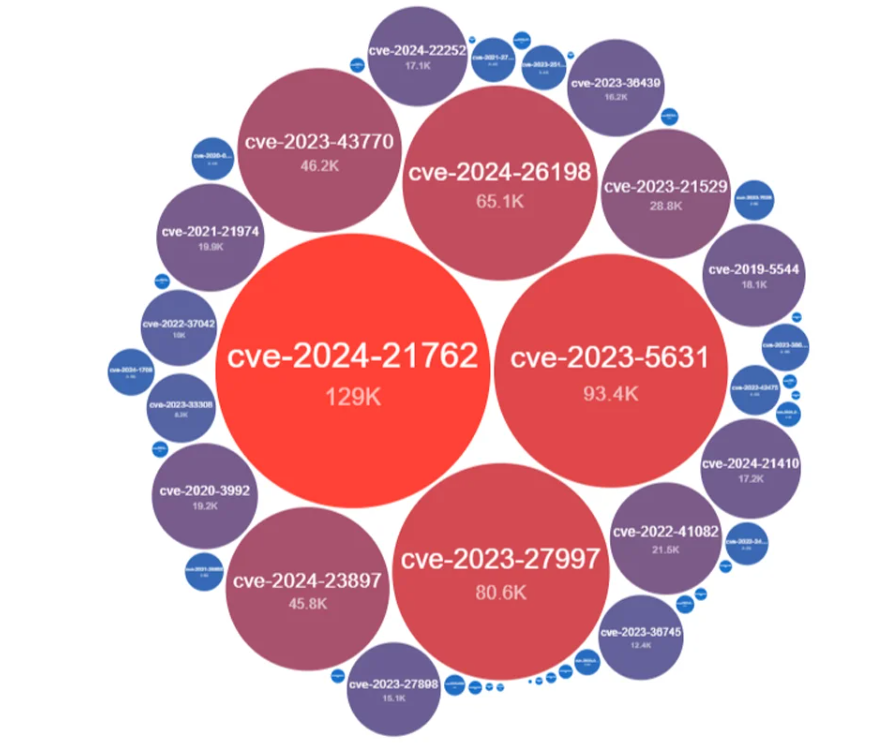

ShadowRay 带来了一个问题,因为 AI 团队将基础设施暴露给公众。然而,许多其他人将互联网上的资源暴露在公众面前,这些资源存在严重的安全漏洞,容易被利用。例如,下图显示了Shadowserver Foundation 检测到的数十万个存在严重漏洞的 IP 地址,这些 IP 地址可以从互联网上访问!

搜索所有级别的漏洞会暴露数百万个潜在问题,但甚至不包括有争议的 CVE,例如 ShadowRay 或其他意外配置错误且可访问的基础设施。使用云原生应用程序保护(CNAP) 平台甚至云资源漏洞扫描程序可以帮助检测暴露的漏洞。

不幸的是,扫描要求 AI 开发团队和其他部署资源的人员将其资源提交给安全部门进行跟踪或扫描。AI 团队可能会出于预算和快速部署的目的独立启动资源,但安全团队仍必须了解这些资源的存在,以便将云安全最佳实践应用于基础设施。

漏洞扫描课程

Anyscale 对 CVE-2023-48022 的争议使该漏洞与许多其他有争议的 CVE 漏洞一起陷入了灰色地带。这些问题包括尚未证实且可能无效的问题,以及产品按预期运行但方式不安全的问题(例如 ShadowRay)。

这些有争议的漏洞值得通过漏洞管理工具或风险管理程序进行跟踪。它们还值得特别关注,因为 ShadowRay 揭示了两个关键教训。首先,漏洞扫描工具在处理有争议的漏洞方面各不相同,其次,这些漏洞需要主动跟踪和验证。

注意争议漏洞处理中的差异

不同的漏洞扫描程序和威胁源将以不同的方式处理有争议的漏洞。有些会忽略有争议的漏洞,有些则可能将其作为可选扫描,而有些则可能将其作为不同类型的问题。

例如,Carpenter 透露,“Orca 采取了将其作为态势风险而非 CVE 式漏洞来处理的方法……对于组织而言,这是一种更易于接受的方法,因为 CVE 通常通过更新来解决(这里不提供),但态势风险是通过配置更改来解决的(这是解决此问题的正确方法)。”IT 团队需要积极跟踪特定工具如何处理特定漏洞。

积极跟踪并验证漏洞

工具承诺使流程更加简单,但遗憾的是,安全的简单按钮尚未出现。对于漏洞扫描器,现有工具是否扫描特定漏洞并不明显。

安全团队必须积极关注哪些漏洞可能会影响 IT 环境,并检查工具是否能检查特定的 CVE。对于有争议的漏洞,可能需要采取其他步骤,例如向漏洞扫描器支持团队提交请求,以验证该工具是否会解决该特定漏洞。

为了进一步降低暴露风险,请使用多种漏洞扫描工具和渗透测试来验证已发现漏洞的潜在风险或发现其他潜在问题。对于 ShadowRay,Anyscale 提供了一种工具,但免费的开源漏洞扫描工具也可以提供有用的额外资源。